Para nadie es una sorpresa que el archivo de robots.txt en blogger o archivo de robots.txt personalizado genera una cantidad de preguntas por parte de los usuarios que no conocen mucho sobre el tema.

Ademas, en este articulo conocerás sobre las Etiquetas de robots personalizadas en blogger ya que este es otro tema de importancia tanto para el blog y para la persona que lo administra.

Me imagino que la primera vez que viste algo de robots.txt fue cuando entraste a la configuración de tu blog y te encontraste con una opción llamada "Habilitar un archivo robots.txt personalizado" y con "Archivo robots.txt personalizado". De acuerdo con esto, te digo que a muchas personas les pasa.

¿Es archivo robots.txt o archivo robots.txt personalizado?Si dices archivo robots.txt o archivo robots.txt personalizado, en realidad es lo mismo. El archivo robots.txt que pertenece a tu blogger se puede personalizar, es decir, que por medio comandos tu puedes hacer que este cumpla con un trabajo. Ademas, simplemente lo puedes estructurar de una manera distinta.

A continuación, se te presentara el indice que contenido:

INDICE:

1-¿Qué es el archivo de robots.txt?

2- ¿Dónde esta el archivo robots.txt en Blogger?

3- Estructura del archivo robots.txt en Blogger.

4- ¿Es archivo robots.txt o archivo robots.txt personalizado?

5- ¿Cómo agregar el archivo robots.txt personalizado en Blogger?

6- ¿Cómo editar o personalizar el archivo robots.txt de Blogger?

7- URL bloqueada por el archivo robots.txt.

8- Comandos utilizados en el archivo robots.txt

9- ¿Cómo habilitar las etiquetas de robots personalizadas?

9.1- Función de las etiquetas de robots personalizadas.

9.2- ¿Cómo utilizar las etiquetas de robots personalizadas en Blogger?

¿Qué es el archivo de robots.txt?

El robots.txt es un archivo que posee una extensión "txt" lo que significa que es "Texto" o en otras palabras, es un archivo de texto simple que tu lo puedes crear o escribir en tu PC haciendo uso del programa Blog de notas.

El robots.txt controla el trafico a nivel de rastreadores para tu blog o pagina web. Ademas, se utiliza para bloquear y/o permitir este nivel de rastreo.

Lo que hoy en día conocemos como el archivo de robots.txt, antes se llamaba protocolo de exclusión de robots.

¿Dónde esta el archivo robots.txt en Blogger?

El administrador de un blog en Blogger, no puede decir lo siguiente: "No tengo el archivo robots.txt" o "No consigo el archivo robots.txt". Este archivo pertenece a tu blogger y para poderlo encontrar, debes hacer lo siguiente.

Primeramente debes ir a tu blog y escribir al lado de tu dominio o subdominio la siguiente frase: robots.txt.

Ejemplo: https://ejemplo15.blogspot.com/robots.txt

Después, debes presionar la tecla "enter" de tu teclado, la pagina cargara y se te mostrara una pagina en blanco con un texto, ese texto es el archivo robots.txt de tu blog.

Estructura del archivo robots.txt en Blogger

Cuando hablamos de "estructura", nos referimos a cada uno de los términos (comandos) que este presenta y que en muchas ocasiones son difícil de interpretar. Ademas, el termino usado con mas frecuencia es "sintaxis del archivo robots.txt".

Grupo 1:

User-agent: Indica el nombre del Robot o de la arañas de google. En la imagen anterior podemos ver el "Mediapartners-Google" pero este en ocasiones puede ser distinto ya que el nombre del robot puede variar y no existirá problema con ello.

Disallow: Significa no permitir. El disallow le dice al User-agent que no acceda, rastree ni indexe a una URL. Pero en te caso el disallow no aparece con nada escrito y por eso el User-agent accede a todas las URL.

Grupo 2:

User-agent: Aquí nos aparece con un "*" y esto significa "Todos", es decir, que permite el acceso a todos los rastreadores o todos los User-agent.

Disallow: Aquí nos aparece con "/search", esto significa que el disallow no lo permite o en otras palabras le dice a todos los User-agent que todas las URL que terminen en "/search" no las rastreen, indexen o accedan.

Allow: Este significa permitir. Este caso aparece con "/" y este le indica a todos los User-agent que todas las URL que terminen en "/" las rastree, indexe y acceda a ellas.

Grupo 3:

En este grupo solo esta el sitemap de tu blog. La URL que se presenta seria la que tu incluirías en la sección de "sitemap" que aparece en tu Google Search Console.

Dato: Así como se muestra en la imagen anterior, es el archivo robots.txt de un blog de blogger, pero en otros CMS como Wix o Wordpress el archivo robots.txt es distinto ya que este en ocasiones no incluye el Allow, sitemap y a veces un solo User-agent.

¿Cómo agregar el archivo robots.txt personalizado en Blogger?

Antes de comenzar debes copiar completo el archivo robots.txt personalizado de tu blogger. Sigue cada uno de los siguientes pasos:

Paso 1: Primero haces clic en Configuración.

Paso 2: Buscaras la opción llamada Rastreadores e indexación.

Paso 3: Te encontraras con dos opciones mas, la primera es Habilitar un archivo robots.txt personalizado y la segunda es Archivo robots.txt personalizado.

Paso 4: La opción de Habilitar un archivo robots.txt personalizado la tienes que activar.

Paso 5: En la segunda opción, archivo robots.txt personalizado, debes hacer clic en ella, luego pegar el archivo robots.txt y después hacer clic en guardar. De esta forma, el archivo robots.txt ya estaría agregado a tu blogger.

¿Cómo editar o personalizar el archivo robots.txt de Blogger?

Para poder editar tu archivo de robots.txt de tu blog debes seguir estos pasos:

Paso 1: Para comenzar, debes hacer clic AQUÍ.

Paso 2: Debes hacer clic en el botón Abrir Herramienta de Probador de Robots.txt.

Paso 4: Para editar el archivo robots.txt personalizado de tu blogger, es decir, si le deseas agregar o eliminar algo, entonces simplemente deberás hacerlo.

Ejemplo: Se eliminara el "/search" que pertenece al Disallow y en el Allow, agregaremos la "/".

Paso 5: Después de eliminar y agregar las indicaciones, deberás hacer clic en el botón Probar y esperar unos segundo a que te aparezca esta linea de color verde.

Paso 6: Continuando, tendrás que hacer clic en el botón Enviar y se mostraran 3 pasos que debemos seguir para que la edición del archivo de robots.txt este completa.

Paso 8: Ahora, regresamos al editor y cumplimos con el siguiente paso que nos indican, hacemos clic en Ver la versión subida. Se nos abrirá una nueva pestaña en donde podremos ver el nuevo archivo de robots.txt de nuestro blog.

Si cuando se abre esta nueva pestaña y aun se les muestra el archivo de robots.txt antiguo, no piensen que hicieron algo mal, solo vuelvan a cargar la pagina para que este nuevo archivo aparezca y si no se muestra, vuelven a cargar la pagina.

Paso 9: Para finalizar, cerramos la pestaña y solamente nos queda cumplir con el ultimo paso. Hacemos clic en el botón Enviar para informarle a Google ya que editamos y cambiamos el archivo de robots.txt de nuestro blogger.

URL bloqueada por el archivo robots.txt

Las URL bloqueadas por el robots.txt es uno de los problemas comunes que podemos encontrar en nuestro Search Console y para solucionar esto de una manera bastante fácil, debes ir y editar tu archivo de robots.txt en la cual deberás quitar la url que se encuentre en el Disallow.

Cada uno de los pasos que debes seguir para cumplir con este proceso, te los nombramos anteriormente.

Comandos utilizados en el archivo robots.txt

Como administrador de un blog en blogger puedes otorgarle una función mas especifica a tu archivo robots.txt personalizado con los siguientes comandos o indicaciones.

Completo acceso a todos los User-agent:

User-agent: *

Disallow:

Bloquear todo el rastreo de tu sitio web o blog:

User-agent: *

Disallow: /

Acceso solo para un User-agent:

User-agent: Mediapartners-Google

Allow: /

User-agent: *

Disallow: /

Acceso a todos los User-agent, excepto a uno:

User-agent: Mediapartners-Google

Disallow: /

User-agent: *

Allow: /

Bloqueo de todas las imágenes sitio, blog o pagina:

User-agent: Googlebot-Image

Disallow: /

Bloqueo de una página web o blog específico:

Disallow: /pagina-ejemplo.html

¿Cómo habilitar las etiquetas de robots personalizadas?

Paso 1: Entras en tu blogger, haces clic en configuración y buscas el apartado de Rastreadores e indexación.

Paso 2: Ahora activas la opción llamada Habilitar las etiquetas de cabeceras de robots personalizadas.

Paso 3: De esta manera ya estarán habilitas las etiquetas de robots personalizadas.

Función de las etiquetas de robots personalizadas

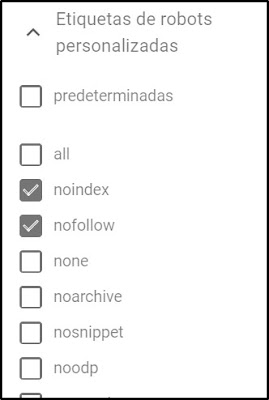

Después de que habilitas las etiquetas de robots personalizadas en tu blogger, puedes entrar a cualquier entrada o pagina de tu blog, ir a Configuración de la entrada o pagina y mirar la nueva opción llamada etiquetas de robots personalizadas. Cuando haces clic en ella, se te mostraran las etiquetas robots en blogger:

all: Significa que no hay bloqueos de indexación ni de publicación.

noindex: No se muestran la página o entradas en los resultados de búsqueda.

nofollow: No se rastrean los enlaces de la página o entrada.

none: Igual a noindex y nofollow.

noarchive: No se muestra ningún enlace en el caché de los resultados de búsqueda generada.

nosnippet: No se observa ningún fragmento y ni la vista previa de ningún vídeo en los resultados de búsqueda.

noodp: Significa que no se utilizan metadatos del proyecto de Open directory para los títulos o los fragmentos que se muestran en la página

notranslate: No se ofrece una traducción de esta página o entrada.

noimageindex: No se indexan las imágenes de una página o entrada.

unavailable_after: No se muestra esta página en los resultados de búsqueda después de la fecha y hora especificadas. La fecha y la hora deben ir en formatos como RFC 822, RFC 850 o ISO 8601.

¿Cómo utilizar las etiquetas de robots personalizadas en Blogger?

En blogger, cuando utilices estas etiquetas debes aplicarlas a paginas muy especificas como: La pagina de Aviso legal, Políticas de Privacidad y Política de Cookies ya que no necesitas y ni es recomendable que estas paginas de tu blogger estén por todo Internet.

Ademas, estas etiquetas no se aplican a entradas o páginas que favorecen a tu blog (que te generen visitas). En un caso muy exclusivo, podrías usar estas etiquetas para ocultar algo de una de tus entradas pero esto sucede muy poco.

Una forma de aplicar estas etiquetas es de la siguiente manera:

Paso 1: Te diriges a tu pagina o entrada a la cual desees aplicarle estas etiquetas.

Paso 2: En configuración de la pagina o entrada, buscas la opción de etiquetas de robots personalizadas y haces clic en ella.

Paso 3: Ahora, solo seleccionaras la etiqueta noindex y nofollow.

Y una super recomendación es que apliques estas etiquetas (noindex y nofollow) en tus paginas de Aviso legal, Políticas de Privacidad y Política de Cookies cuando las recién creas.

En conclusión

El contenido del Robots.txt es bastante largo y en ocasión un poco difícil de entender. El archivo robots.txt de tu blog, pagina web o sitio web se puede editar y siempre es necesario darle importancia ya que este controla el trafico de los rastreadores a tu blog.

¡Recuerda que siempre puedes comentar!

En realidad estuvo muy bien este artículo, aprendí a actualizarlo que era lo que en realidad necesitaba. Gracias bro

ResponderBorrarMuchas gracias a ti y excelente que te funcionara

Borrarpregunta, que significa en las etiquetas personalizadas "predeterminado" "all" y no marcar ninguna.

ResponderBorrarHola Alberto, muchas gracias por este detallado articulo. Te comento, ya van a hacer dos semanas que tengo mi blog publicado y estube trabajando duro en el, ya tiene 7 publicaciones, una apariencia respetable y lo indexe en search console y big tools pero sigo figurando en ambas plataformas con 0 pajinas indexadas ademas que el comando sit: no me devuelve nada... en base a leer tu articulo entre en cada una de las entradas y le cambie la etiqueta de predeterminada a all. Pero me quede pensando el lo del archivo robot.txt. Le hago las reformas que incuiste en el post? ya estoy algo mareado porque otras fuentes dicen que al ser un servicio de google no hace falta cambiar nada para que indexe... perdon si te marie pero tengo la mente hecha un nudo. jaja helpmeeee

ResponderBorrar